È stato approvato un disegno di legge che impone che gli sviluppatori degli algoritmi debbano rispondere dei danni critici che potrebbero causare. Il punto è capire quale possa essere il giusto equilibrio fra sicurezza e innovazione

Lo sviluppo impressionante dell’intelligenza artificiale si accompagna da tempo a un dibattito su quale possa esserne la giusta regolamentazione, fra confini normativi e limiti etici. Ma questo discorso è ancora più controverso se a porre dei limiti è uno stato che basa la sua ricchezza sull’innovazione: un luogo del mondo dove l’industria della tecnologia ha costruito il suo paradiso, fidandosi della promessa che da lì sarebbe riuscita a conquistare il mondo.

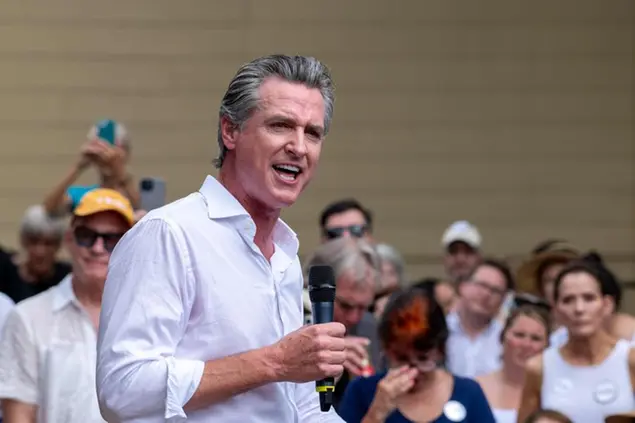

È proprio per questo che si sta molto discutendo di un nuovo disegno di legge sull’intelligenza artificiale che è stato approvato in California e che attende ora solo la firma del governatore, il democratico Gavin Newsom. Il cambiamento non è all’ordine del giorno, visto che nel caso entrerà in vigore solo da gennaio 2026. Ma per chi costruisce il futuro avendo orizzonti molto ampi la data è comunque estremamente ravvicinata.

Sb 1047

E così si iniziano a misurare le possibili implicazioni di un insieme di norme – riunite sotto alla sigla futuristica “Sb 1047” che potrebbe essere benissimo il nome di un robot (e che in realtà significa semplicemente “Senate Bill 1047”) –, che ha un punto cardine potenzialmente devastante: gli sviluppatori saranno chiamati a rispondere degli eventuali danni causati dai loro algoritmi. Significa, per esempio, che se un utente dovesse riuscire ad hackerare un sistema governativo di controllo delle testate nucleari con l’aiuto dell’intelligenza artificiale, sarà chiamato a risponderne anche lo sviluppatore che lo ha ideato.

In realtà, il punto principale della legge è proprio quello di immaginare un progresso meno incontrollato, che preveda un insieme di test e salvaguardie automatizzate, capaci di frenare le possibili derive della tecnologia. Ma dalla Silicon Valley è già partita un’intensa attività di lobbying per riuscire a limare le norme, se non addirittura a farle saltare, usando come scusa anche un principio: un tema così importante non può essere normato a livello locale, ma dovrebbe avere una legislazione unica per tutti gli Stati Uniti.

Così a livello nazionale – e nel contesto di una campagna elettorale che è influenzata anche da questi temi – non sono mancate critiche importanti, spesso provenienti anche dallo stesso campo democratico. Nancy Pelosi, ad esempio, ha detto che la legge è sì sacrosanta, ma dovrebbe essere ben meditata per non ostacolare il progresso. Il rischio potrebbe essere un esodo delle più importanti aziende tecnologiche, che potrebbero lasciare la Silicon Valley per altri stati più permissivi. La prospettiva sembra più una minaccia che una possibile realtà, ma segue l’esempio di Elon Musk, che già ha detto di voler spostare le sue aziende nel Texas, in quel caso contro le leggi che favoriscono gli studenti trasgender nelle scuole.

Paradossalmente, fra le voci fuori dal coro nel mondo della tecnologia sull’Sb 1047 c’è proprio Musk, che ha detto di essere invece favorevole a questo provvedimento contro le derive dell’intelligenza artificiale. È un passo importante, ha detto, visti i rischi rappresentati dall’intelligenza artificiale.

Il fronte dei contrari è invece molto ampio e comprende, fra gli altri, giganti tecnologici come OpenAi, Google e Meta.

Danni critici

La legislazione californiana ha il merito di introdurre per la prima volta il concetto di “danni critici”, dal potenziale catastrofico, che sono appunto quelli che vengono severamente puniti, estendendo la responsabilità anche agli sviluppatori dell’algoritmo. In particolare, la legge prevede tre categorie principali: quando l’uso di un modello di intelligenza artificiale causa un numero significativo di vittime umane, come attacchi terroristici o altre forme di violenza su larga scala. Ci sono poi i “danni economici gravi”, che superano i 500 milioni di dollari. In questa categoria possono rientrare gli attacchi informatici che compromettono sistemi finanziari o altri settori critici dell’economia.

Infine, c’è un ultimo punto, che è anche il più controverso: quello degli “altri danni di gravità comparabile”. È una clausola generale, che potrebbe comprendere ad esempio la creazione di armi automatiche o gli attacchi a infrastrutture critiche. Secondo i critici della legislazione, il rischio è però che una formula “troppo generica” possa essere un potenziale freno allo sviluppo.

Un altro concetto introdotto dalla legge (e in realtà già teorizzato in alcuni libri di fantascienza) è che l’uomo debba sempre avere un controllo sui modelli di intelligenza artificiale che sviluppa. Anche rispetto al possibile uso che ne farà un utente.

In particolare, i modelli dovranno essere sottoposti a test rigorosi prima di essere messi in commercio o distribuiti. Dovrebbero anche tenere conto di ogni uso improprio e della possibilità che ne vengano sfruttate le eventuali vulnerabilità.

Gli sviluppatori dovrebbero inoltre installare misure di sicurezza informatiche per proteggere gli algoritmi da eventuali manipolazioni. Infine – ed è l’aspetto più interessante – dovrebbe essere prevista una sorta di “capacità di arresto”: il fatto che gli sviluppatori possano in qualsiasi momento intervenire in caso di emergenza, per interrompere l’operatività dei loro modelli.

Non dobbiamo pensare ad una sorta di interruttore della morte, da far scattare se un algoritmo è utilizzato per fare del male. Potrebbero essere dei protocolli che consentano agli sviluppatori di agire tempestivamente per prevenire danni su larga scala.

Il dibattito filosofico

È difficile capire se il disegno di legge riuscirà a superare le forche caudine messe in campo dalle lobby della tecnologia. Ed è presto anche per capire quali potranno poi essere eventualmente le conseguenze concrete, rispetto a una tecnologia che tende a evolvere in maniera più rapida di qualsiasi legge.

Il discorso supera però anche questi aspetti, per quanto importanti, e finisce per coinvolgere in maniera più ampia il dibattito filosofico che accompagna l’evoluzione dell’intelligenza artificiale. Per capirne i rischi, non serve immaginare scenari distopici, né condividere per forza il rischio dei “danni critici” immaginati in California. Il punto è capire che uno strumento tecnologico è di per sé neutro: può essere utilizzato per portare enormi benefici, a partire dalle promesse di ricchezza che caratterizzano il sogno della Silicon Valley. Ma, senza regolamentazioni, può portare anche a grossi danni.

La questione non è dunque solo tecnica, ma tocca il cuore del rapporto tra tecnologia e società. Mentre l’intelligenza artificiale evolve a un ritmo sempre più rapido, è essenziale che le regolamentazioni siano sufficientemente flessibili da permettere l’innovazione, ma anche abbastanza rigorose da prevenire scenari potenzialmente catastrofici. La sfida è capire dove sta il giusto equilibrio.

© Riproduzione riservata