- Anche i più potenti supercomputer del mondo non sono in grado di simulare i fenomeni governati dalla fisica quantistica o particolarmente complessi

- È qui che entrano in gioco i computer quantistici, che sfruttano caratteristiche come la sovrapposizione e l’entanglement per aumentare esponenzialmente la loro potenza di calcolo

- A oggi, però, esistono solo macchine dalle capacità molto ridotte e che sono particolarmente inclini a fornire risultati completamente casuali

Nel 1982, il premio Nobel per la fisica, Richard Feynman, teorizzò la necessità di sviluppare dei computer quantistici. Senza queste macchine, spiegò Feynman, sarebbe stato impossibile simulare per via informatica i fenomeni governati dalla fisica quantistica, che proprio per questa ragione sono fuori dalla portata anche dei più potenti computer tradizionali. Un classico processore, infatti, utilizza i bit (binary unit): una specie di microscopico interruttore che può trovarsi alternativamente nella posizione spenta (rappresentata dallo zero) o accesa (rappresentata dall’uno).

Ogni sito che visitate, mp3 che ascoltate, fotografia digitale che scattate e anche film su Netflix che guardate, alla sua base, è rappresentato da una lunghissima sequenza binaria di 0 e 1.

È un sistema che funziona perfettamente nella maggior parte dei casi, ma che non è in grado di rappresentare il funzionamento della natura su scala atomica e subatomica: nemmeno i potentissimi supercomputer che occupano interi piani dei più avanzati centri ricerca del mondo (e che arrivano fino a 400 milioni di miliardi di operazioni al secondo) sono in grado di oltrepassare questo fondamentale ostacolo.

Per superarlo, e riuscire a simulare un fenomeno quantistico, sono quindi necessari dei computer non più basati sui bit, ma sui qubit (quantum bit). Queste unità digitali sfruttano infatti alcune proprietà della meccanica quantistica per aumentare esponenzialmente la loro velocità di calcolo. Il primo di questi principi è quello della sovrapposizione: invece di essere soltanto accesi o spenti, i qubit possono essere in entrambe le posizioni, e in tutte quelle intermedie, allo stesso tempo.

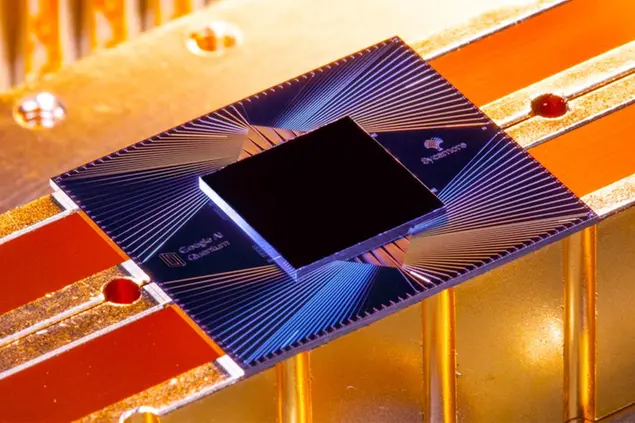

Grazie a questo fenomeno controintuitivo – che società come Ibm, Google e Rigetti sono in grado di produrre utilizzando circuiti superconduttori raffreddati a temperature prossime allo zero assoluto (-273°) – un computer quantistico dotato di una certa quantità di qubit può analizzare un vasto numero di possibilità contemporaneamente: il risultato finale del calcolo emerge nel momento in cui i qubit vengono misurati, il che li fa immediatamente “collassare” dal loro stato quantistico a una tradizionale posizione binaria.

Il secondo principio su cui si basano i computer quantistici è quello dell’entanglement, che in campo informatico prevede che una determinata coppia di qubit esista sempre nello stesso stato quantico. Grazie a questa proprietà, nel momento in cui si modifica lo stato di un qubit cambierà immediatamente anche lo stato del qubit a esso associato, indipendentemente dalla distanza a cui si trova. Nessuno sa esattamente perché o come ciò avvenga – Einstein l’ha notoriamente definito “spaventosa azione a distanza” – ma per merito di questi fenomeni un computer quantistico dotato per esempio di 50 qubit può possedere contemporaneamente due stati elevati alla 50esima potenza.

I rischi

A quasi quarant’anni da quando Feynman teorizzò tutto ciò, è più o meno questo il punto a cui siamo arrivati: il processore quantistico Sycamore, di Google, sfrutta infatti 53 qubit, mentre l’Hummingbird di Ibm arriva a 65 e lo stesso vale per i più avanzati progetti di ricerca cinesi. Ma quali possono essere le applicazioni pratiche di queste macchine? Prima di dare un’occhiata alle potenzialità, può essere interessante partire dai rischi: nel 1994, l’informatico teorico Peter Shor scoprì che un computer quantistico avrebbe potuto decifrare tutti i sistemi crittografici che oggi proteggono le transazioni che avvengono su internet. I sistemi di sicurezza online si basano infatti sull’enorme quantità di tempo e di energia che i computer tradizionali devono impiegare per decifrarli. Questo, però, non varrà per i computer quantistici, che saranno in grado di crackare rapidamente qualsiasi protezione.

La supremazia quantistica

Quanto manca prima che questo scenario, in grado di mettere a rischio l’economia mondiale, si verifichi? A dire il vero, siamo ancora molto lontani. Per il momento, infatti, siamo solo nell’epoca della cosiddetta “supremazia quantistica”. Nonostante il nome altisonante, questo termine indica semplicemente che in un’occasione un computer quantistico – il Sycamore di Google nel 2019 – è effettivamente riuscito a risolvere in pochi minuti un calcolo che per un tradizionale computer avrebbe richiesto un lasso di tempo irragionevole (nell’ordine delle migliaia di anni).

Si è però trattato di una dimostrazione teorica, priva di applicazioni pratiche e progettata dai ricercatori al solo scopo di mostrare le potenzialità del Sycamore. Non significa che i computer quantistici di oggi siano pronti per essere messi all’opera sui più complessi problemi che l’essere umano deve fronteggiare, tutt’altro: «È un traguardo che bisogna superare per iniziare a ottenere risultati, ma non produrrà nessuna immediata conseguenza», ha spiegato all’edizione britannica di Wired il docente di tecnologie quantistiche Simon Benjamin. Per il momento, insomma, la supremazia quantistica ha avuto il solo scopo di dimostrare che questi computer effettivamente possono fare ciò che è impossibile per quelli tradizionali, sfruttando esperimenti progettati esattamente a questo scopo.

Il raggiungimento della supremazia quantistica ci ha comunque proiettati in una nuova era, definita dagli scienziati Nisq (noisy intermediate-scale quantum). L’obiettivo, adesso, è quindi di sviluppare computer quantistici di taglia intermedia – cioè con un numero ancora limitato di qubit – pur sapendo che il rumore di fondo ci permetterà di avere soltanto un controllo parziale sui risultati che si possono ottenere. La ragione di questa fondamentale limitazione è che anche i più promettenti computer quantistici oggi a disposizione sono incredibilmente inclini all’errore. Immaginate di chiedere al vostro computer di eseguire un calcolo e ritrovarvi una volta su cento con un risultato completamente casuale. Se considerate che in un normale programma può essere necessario eseguire milioni di singoli calcoli, si capisce come al momento sia impossibile pretendere che queste macchine forniscano un qualunque risultato utile.

La causa di questo enorme ostacolo è nota come “decoerenza”. In poche parole, l’interazione tra i qubit e l’ambiente che li circonda causa il decadimento dallo stato quantistico prima che il loro lavoro sia stato portato a termine. Lo stato quantistico è infatti qualcosa di estremamente delicato: le più piccole vibrazioni (anche una collisione tra particelle d’aria) o dei minimi cambiamenti nella temperatura possono farli uscire anticipatamente dalla sovrapposizione in cui si trovano, fornendo risultati completamente casuali. È per questo che, per esempio, il Q System One di Ibm è protetto da una teca di vetro a chiusura ermetica munita di un sistema di raffreddamento prossimo allo zero assoluto.

Ricadute pratiche

La sfida, adesso, è quindi di riuscire comunque a usare i computer quantistici per problemi reali, per esempio migliorando l’hardware al punto che i computer quantistici forniscano risultati utili anche con un numero limitato di qubit (che limita a sua volta il rischio di decoerenza). L’unica soluzione complessiva al problema, invece, è nota come “correzione dell’errore quantistico”. I ricercatori stanno però solo oggi iniziando a sperimentare metodi di correzione degli errori e prima di poterli effettivamente impiegare ci vorrà ancora molto tempo. Per questa ragione, quando si legge di esperimenti condotti con computer quantistici da 50 o 60 qubit, è necessario tenere presente che si tratta di qubit i cui errori non sono stati corretti.

Ma una volta superati questi ostacoli, fino a dove potranno arrivare i computer quantistici? Prima di tutto, queste sono macchine destinate a essere impiegate probabilmente per sempre a solo scopo scientifico e non rimpiazzeranno mai i computer tradizionali (non vi ritroverete un giorno con un iPhone Q in tasca, insomma). Alcuni problemi, molto complessi e particolari, potrebbero però trarre enorme giovamento dall’arrivo dei computer quantistici.

Tra questi c’è la modellazione delle reazioni chimiche: i supercomputer oggi sono in grado di analizzare soltanto le molecole più basilari, mentre i computer quantistici – sfruttando le stesse proprietà delle molecole che stanno cercando di simulare – non dovrebbero avere problemi a gestire anche le reazioni più complesse. I qubit permetterebbero così di progettare nuovi materiali per le batterie delle auto elettriche, di sviluppare più rapidamente nuovi farmaci o di creare pannelli solari estremamente più efficienti. Altri prevedono un miglioramento esponenziale nelle scienze meteorologiche, nel campo dell’intelligenza artificiale, nella sismografia, nell’analisi dei mercati finanziari e più in generale in tutti quei settori particolarmente complessi e dominati da grande incertezza.

L’esempio classico di un problema risolvibile (forse) solo da un computer quantistico è quello del commesso viaggiatore che deve trovare la strada ottimale per visitare un tot numero di città. Un problema che, all’aumentare del numero delle città in cui bisogna fare tappa, diventa talmente complesso da essere irrisolvibile anche per il più potente supercomputer del mondo (bastano venti città per generare oltre due miliardi di miliardi di soluzioni differenti). Non dovendo analizzare un solo percorso per volta, come farebbe un computer classico, ma sfruttando le caratteristiche della fisica quantistica per testarli tutti contemporaneamente, un sistema con un sufficiente numero di qubit potrebbe (almeno teoricamente) darci finalmente la risposta a un problema su cui matematici e informatici si spaccano la testa da decenni.

© Riproduzione riservata