- È davvero possibile usare i dati del passato per prevedere ciò che avverrà in futuro? Era questo l’obiettivo della polizia predittiva

- Più che supportare le forze dell’ordine, questi sistemi hanno contribuito a mettere sotto pressione gli abitanti delle zone più difficili della città e dare vita a profezie che si autoavverano

- Il Parlamento Europeo ha proposto la loro messa al bando e anche negli Stati Uniti sono stati spesso abbandonati, ma il loro fallimento è la spia di un problema più generale

Ci sono casi in cui la polizia predittiva sembra funzionare alla perfezione. Nel 2013, per esempio, l’algoritmo di intelligenza artificiale che aiutava le forze dell’ordine di Chicago a individuare potenziali persone sospette aveva stimato che tale Robert McDaniel avesse il 99,9 per cento di probabilità di venire coinvolto in una sparatoria, come aggressore oppure come vittima.

Da allora, McDaniel è stato effettivamente vittima due volte di aggressioni armate: nel 2017 e nel 2020, sopravvivendo a entrambe.

A prima vista, il sistema di polizia predittiva – creato da un ingegnere informatico dell’Illinois Institute of Technology – è riuscito in un’impresa straordinaria: segnalare alla polizia chi in futuro sarebbe stato coinvolto in crimini violenti.

Secondo un’inchiesta condotta da The Verge, le cose sono in realtà andate molto diversamente. Nella più classica delle profezie che si autoavverano, è stata proprio la previsione dell’algoritmo a condannare McDaniel, che fino a quel momento non era mai stato coinvolto in crimini violenti (ma solo fermato per vendita di marijuana). Com’è possibile?

Stando alla ricostruzione, la segnalazione del sistema di polizia predittiva ha innescato una sorveglianza costante della polizia nei confronti di McDaniels, residente in uno dei quartieri più problematici di Chicago.

Essendo una sorveglianza in parte manifesta (la volante stazionava spesso davanti a casa, ecc.), alcuni abitanti del quartiere hanno iniziato a sospettare che potesse esserci una connessione di qualche tipo tra McDaniel e la polizia.

Per esempio, che McDaniel potesse essere un informatore. Per quale ragione, d’altra parte, la polizia dovrebbe prestare attenzione a una persona che non aveva mai fatto nulla di particolare?

Come scritto da Matt Stroud nella sua inchiesta: «La segnalazione dell’algoritmo ha provocato il danno che i suoi creatori speravano di evitare: ha previsto una sparatoria che non si sarebbe verificata se non fosse stata prevista».

Errori pesanti

Nonostante l’eccezionalità di questo caso, la propensione del sistema usato dalla polizia di Chicago a segnalare persone senza particolari ragioni, sottoponendole così a ripetuti controlli, è ben documentata.

Secondo un report dello stesso comune di Chicago, solo il 16 per cento delle persone inserite nella lista dei “sospetti strategici” sono poi state confermate essere parte di qualche gang o coinvolte in attività violente.

Nonostante le promesse di elevata accuratezza, il sistema, alla prova sul campo, si è dimostrato tutt’altro che preciso. E lo stesso sta avvenendo un po’ con tutti gli algoritmi di polizia predittiva che, durante lo scorso decennio, si sono diffusi con la speranza di contribuire al contrasto del crimine attraverso l’analisi dei big data ricavati da rapporti, testimonianze e altro.

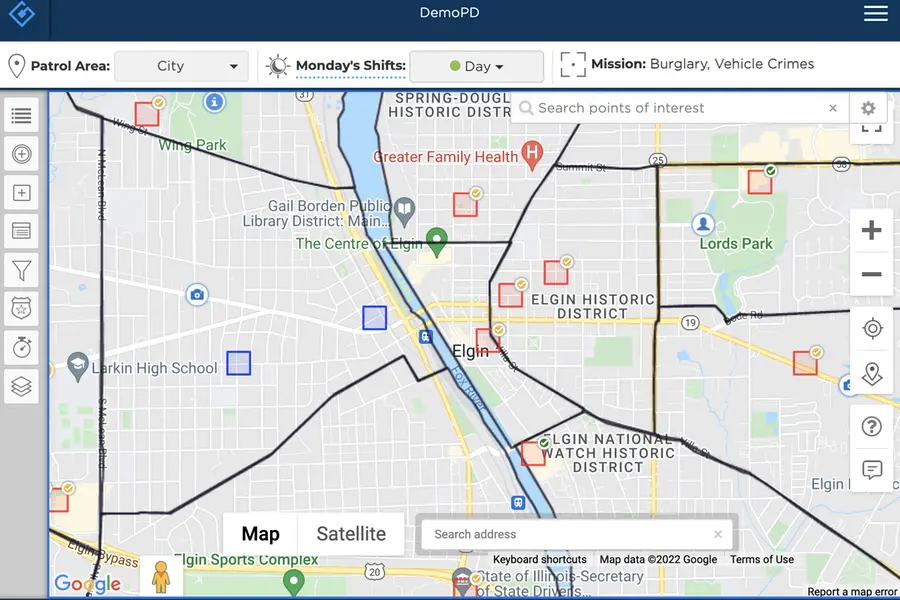

Se però lo strumento usato a Chicago aveva l’obiettivo di individuare le persone da sorvegliare, altri funzionano diversamente: il noto PredPol, come anche KeyStats, Gotham di Palantir o RTM, segnalano le aree più a rischio e gli orari in cui tenerle d’occhio; il software italiano KeyCrime ha invece l’ambizione di individuare dove colpirà prossimamente un criminale seriale analizzando i suoi comportamenti precedenti.

In generale, il meccanismo alla base di questi sistemi è però simile: un algoritmo viene addestrato usando i dati relativi ai crimini compiuti – i rapporti di polizia, il registro degli arresti e le targhe identificate; ma anche gli orari, il periodo dell’anno e addirittura le condizioni meteo in cui sono stati commessi delitti o furti – con l’obiettivo di individuare correlazioni e schemi ricorrenti nei crimini, prevedendo così dove e quando si verificheranno in futuro con maggiore probabilità.

Pregiudizi scientifici

Come però segnalato in innumerevoli studi (il più recente dei quali è Discriminating Data di Wendy Chun, pubblicato dalla MIT Press), questi strumenti non solo spesso non funzionano, ma perpetuano gli stessi pregiudizi già presenti nella società, arrivando addirittura a ostacolare il progresso: «Al posto di anticipare ciò che potrebbe avvenire, ricavandolo dalla miriade di ignote possibilità dalle quali la stessa idea di futuro dipende, il machine learning e gli altri metodi di correlazione statistica basati su intelligenza artificiale restringono il futuro a ciò che stato il passato», si legge in un’analisi del saggio.

In poche parole, questi sistemi, invece di prevedere il futuro, si assicurano che il passato continui a riproporsi sempre identico.

Per esempio, le persone che vivono nei quartieri difficili – che sono spesso appartenenti alle minoranze etniche – hanno più probabilità di essere arrestate, ma ciò è causato anche dal fatto che quelle stesse zone tendono a essere maggiormente pattugliate.

Di conseguenza, i dati che vengono forniti agli algoritmi di polizia predittiva si limiteranno a indicare che queste sono le aree a maggiore densità criminale, creando un circolo vizioso che porterà sempre più persone a essere fermate, perquisite e controllate per il solo fatto di abitare in un quartiere difficile (esattamente ciò che è avvenuto a Robert McDaniel).

«Quando la polizia prende di mira una determinata area, ciò genera più rapporti di crimini, arresti e controlli, i dati così creati porteranno gli algoritmi e gli altri strumenti di valutazione del rischio a dirigere la polizia sempre nella stessa area», spiega uno studio della ong Stop LAPD Spying.

Nella maggior parte dei casi, insomma, i sistemi di polizia predittiva non fanno altro che giustificare algoritmicamente quello che spesso è già il comportamento delle forze dell’ordine.

Questa evidente criticità – unita alla scarsa accuratezza e ai soprusi generati – ha fatto sì che numerosi dipartimenti decidessero di abbandonare i sistemi predittivi: la polizia di Chicago l’ha dismesso nel 2020, così come hanno fatto quella di Palo Alto e Los Angeles (California), New Mexico (dove il capitano della polizia di Rio Rancho ha commentato: «Non ci diceva nulla che non sapessimo già») e anche in Europa, per esempio nella contea britannica del Kent.2

I convertiti

Nonostante questi strumenti siano ancora usati – o lo fossero fino a poco fa – in decine di città statunitensi e anche nei Paesi Bassi, in Danimarca e altrove in Europa, la fortuna dei sistemi di polizia predittiva basati su intelligenza artificiale sembra stia gradualmente giungendo al capolinea.

Lo dimostra anche il rebranding effettuato da PredPol, che ha da poco cambiato nome in Geolitica proprio per ridurre l’enfasi sull’aspetto predittivo.

Una società come HunchLab ha fatto addirittura inversione di marcia: dopo anni nel settore della polizia predittiva, ha oggi cambiato nome in ShotSpotter e dichiara di voler “mitigare gli eccessi della polizia in favore di un coinvolgimento positivo della comunità”.

Un approccio simile è stato tentato da un gruppo di ricercatori dell’Università di Chicago, che – dopo aver annunciato il loro sistema di polizia predittiva nel luglio di quest’anno e averne vantato un’efficacia pari al 90 per cento – hanno invece descritto come questo sistema possa essere utilizzato proprio per monitorare il comportamento della polizia: il loro algoritmo avrebbe infatti svelato come, nelle sette città in cui è stato sperimentato, le forze dell’ordine tendessero a rispondere più prontamente alle richieste provenienti da quartieri ricchi e a maggioranza bianca.

«Il passato non può dirci nulla sul futuro», ha spiegato il ricercatore a capo del progetto, Ishanu Chattopadhyay. «Quello che possiamo fare è invece fornire delle prove alle persone che si lamentano del fatto che le forze dell’ordine ignorano i loro quartieri quando c’è un picco di violenza o dei crimini contro la proprietà. Il nostro sistema permette di quantificare tutto ciò».

Insomma, lo stesso strumento accusato di rafforzare i pregiudizi può essere anche usato per svelarli. Un tentativo estremo di dare un nuovo scopo a strumenti che, col tempo, hanno dimostrato di avere criticità talmente macroscopiche da rendere impossibile ignorarle. E questo vale a maggior ragione in Unione europea, dove il regolamento sull’intelligenza artificiale che sta prendendo forma al Parlamento Europeo prevede esplicitamente la totale messa al bando di ogni forma di polizia predittiva.

La speranza è che l’iniziativa del parlamento europeo contribuisca a mettere in discussione tutti i sistemi che fanno affidamento sui dati del passato per dare forma al futuro.

Al momento le cose sembrano però andare in direzione opposta, anche in Italia: lo dimostra sia la proposta del ministero dell’Università di utilizzare gli algoritmi di machine learning per selezionare i docenti, sia quella di Fratelli d’Italia, che li vuole invece impiegare per trovare lavoro ai giovani. Il fallimento della polizia predittiva riuscirà ad aprirci gli occhi sui limiti dell’intelligenza artificiale?

© Riproduzione riservata