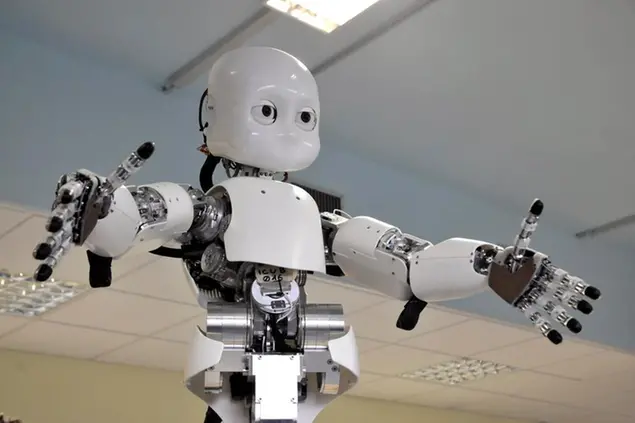

- Più l’intelligenza artificiale diventerà sofisticata e si avvicinerà a un’intelligenza e una autocoscienza vera e propria (la cosiddetta Artificial General Intelligence) più aumenteranno le sfide per integrare nella società questi robot “senzienti”.

- Ad oggi gli automi assomigliano agli schiavi artificiali di Aristotele, macchine prive di volontà che estendono le potenzialità del proprietario. Ne consegue che ogni responsabilità per il loro comportamento è di quest’ultimo.

- Si tratta però di una logica che rischia di diventare sempre più obsoleta via via che il legame simbiotico fra un automa e il suo “padrone” umano si allenta.

Siamo pronti per un futuro in cui le macchine e i software che le alimentano diventeranno sempre più intelligenti, in grado di imparare dall’esperienza e di escogitare soluzioni inedite e incomprensibili anche per i loro creatori?

Non è una domanda retorica. In parte questo futuro è già qui. L’intelligenza artificiale è sempre più diffusa e alimenta i programmi che selezionano i candidati per un posto di lavoro, gli automi collaborativi usati nelle catene di montaggio e nei magazzini, i software di riconoscimento facciale e autenticazione vocale.

Si tratta però di una forma ancora limitata di intelligenza artificiale, conosciuta dagli esperti come artificial narrow intelligence, in cui le macchine sostanzialmente catalogano vari tipi di oggetti e le loro correlazioni per individuare schemi di comportamento da seguire. Non parliamo certo ancora di entità dotate di autocoscienza o di capacità simili a quelle del cervello umano.

Più l’intelligenza artificiale diventerà sofisticata e si avvicinerà a un’intelligenza e una autocoscienza vera (la cosiddetta artificial general intelligence) più aumenteranno le sfide per integrare nella società questi robot “senzienti”.

È difficile, ad esempio, ipotizzare cosa accadrà nel momento in cui le macchine dovessero essere in grado di “provare” piacere o dolore e quindi temere punizioni o cercare ricompense per i loro comportamenti.

Fino a che punto potrebbero proteggere la loro esistenza da conseguenze indesiderate? Potrebbero ad esempio, nel caso dei robot per usi militari, rifiutarsi di smantellare una bomba per non subire danni (anche se si tratta di danni che potrebbero essere facilmente riparati)?

O, addirittura, ricorreranno a pratiche scorrette per ottenere un certo risultato, nella quasi certezza di non essere punite? Non è difficile ipotizzare un’intelligenza artificiale che analizzi miliardi di processi in tribunale e di sentenze seguite a un dato comportamento e decida di commettere un’azione illegale, sapendo che la probabilità di farla franca è molto elevata.

SCHIAVI ARTIFICIALI

Anche allo stato attuale, comunque, non mancano i problemi. Per esempio, nel 2015 la polizia svizzera ha “arrestato” un bot per lo shopping online chiamato “Random darknet shopper” che stava facendo acquisti illegali (droga compresa) sul dark web, mentre recentemente dei veicoli a guida autonoma sono stati coinvolti in incidenti mortali.

In questi casi, si pone il problema della responsabilità giuridica. Di chi è la colpa del misfatto? Del produttore, dell’utilizzatore o della macchina stessa?

Quattro anni fa il parlamento europeo aveva timidamente accennato alla possibilità di attribuire ai robot una forma di personalità giuridica simile a quella delle aziende. Secondo i proponenti questo avrebbe permesso, ad esempio, di tassare e assicurare gli automi (o i software di intelligenza artificiale), semplificando la questione dei risarcimenti e della responsabilità nel caso provocassero danni di qualche tipo.

Apriti cielo. Più di 150 esperti da tutta Europa inviarono una lettera aperta, stigmatizzando l’iniziativa come un modo “furbo” di esentare i produttori da ogni responsabilità.

Più alle grandi corporation, secondo questa scuola di pensiero, gli automi assomigliano agli schiavi artificiali di Aristotele, macchine prive di volontà che estendono le potenzialità del proprietario. Ne consegue che ogni responsabilità per il loro comportamento è di quest’ultimo.

Si tratta però di una logica che rischia di diventare sempre più obsoleta via via che il legame simbiotico fra un automa e il suo “padrone” umano si allenta.

COSCIENZA E RESPONSABILITÀ

Più la tecnologia trasforma il mondo, più apre la porta a interrogativi di ordine filosofico. Diversi esperti e addetti ai lavori (da filosofi come Remo Bodei a manager come Marco Landi) hanno sottolineato come lo sviluppo dell’intelligenza artificiale spinga inevitabilmente a porsi domande di non semplice soluzione sulla natura stessa dell’intelligenza umana, sul rapporto della nostra specie con gli strumenti di cui si serve per raggiungere i propri scopi, sull’esistenza o meno della coscienza e del libero arbitrio.

Concetti che possono apparire a prima vista molto astratti, ma che hanno conseguenze pratiche importanti nel momento in cui si cerca di far sì che le intelligenze artificiali si comportino in maniera “etica”. Semplificando assai un dibattito molto complesso, se gli essere umani distinguono il bene dal male per una sorta di “legge morale” inscritta in loro e possono scegliere liberamente a quale dei due attenersi (come ritengono ad esempio la dottrina e la filosofia di stampo cattolico), solo l’agire umano è autenticamente morale.

Una macchina potrà tutt’al più scimmiottare il giusto e l’ingiusto, ma come un infante non consapevole delle conseguenze delle proprie azioni, la responsabilità dei suoi atti ricadrà comunque sempre sui genitori.

Se invece, come in una delle teorie presentate dallo storico Yuval Noah Harari in Homo Deus, l’agire umano è semplicemente il frutto di processi biochimici di cui è possibile manipolare il funzionamento, la coscienza un’illusione generata da sistemi cerebrali ancora ignoti, il libero arbitrio come lo intendiamo solitamente non esiste.

L’agire umano non è, a questo punto, intrinsecamente “migliore” o più morale di quello di una macchina. Un robot molto sofisticato potrebbe acquisire uno status giuridico e una responsabilità civile e penale almeno per certi versi simile a quella di una persona senza dar troppo scandalo.

Altri motivi di riflessione nascono da quella che il professor Nick Bostrom dell’Università di Oxford definisce Superintelligenza e altri studiosi associano a un evento spartiacque, la “singolarità”. In questo scenario, si giunge alla creazione (o alla auto-generazione, per effetto di un salto evolutivo rispetto alle generazioni precedenti di intelligenza artificiale) di macchine dotate di intelligenza infinitamente superiore a quella umana, un’intelligenza che probabilmente assumerebbe una forma non antropomorfa, ovvero non sarebbe in nessun modo paragonabile a quella che oggi definiamo come tale.

Il livello successivo

Se ciò avvenisse, ne conseguirebbero alcuni corollari interessanti. Una intelligenza artificiale, scrive Bostrom, potrebbe perseguire i propri scopi e avere motivazioni proprie, non legate a quelle umane. Potrebbe, di converso, acquisire uno status etico e morale superiore all’umano, grazie alla capacità di intravedere tutte le ramificazioni e le conseguenze di una determinata scelta e di risolvere problemi altrimenti irrisolvibili.

Non sarebbe niente di nuovo. In fondo per millenni il genere umano ha presentato offerte e venerato oracoli e divinità in grado di formulare previsioni e far avverare richieste. Come per le suppliche tradizionali, però, non è detto che funzionino. E anche se così fosse, non è detto che le risposte ci piacerebbero.

© Riproduzione riservata