Il progresso tecnologico porterà a nuovi costi ambientali e a dubbi ancora irrisolti su come dovrà essere regolamentato: una questione difficile da risolvere, anche considerando la concorrenza della Cina

Questo articolo fa parte della newsletter settimanale “L’America di Domani”, riservata alle abbonate e agli abbonati. Per riceverla fino al 5 novembre e leggere tutte le newsletter precedenti, abbonati qui

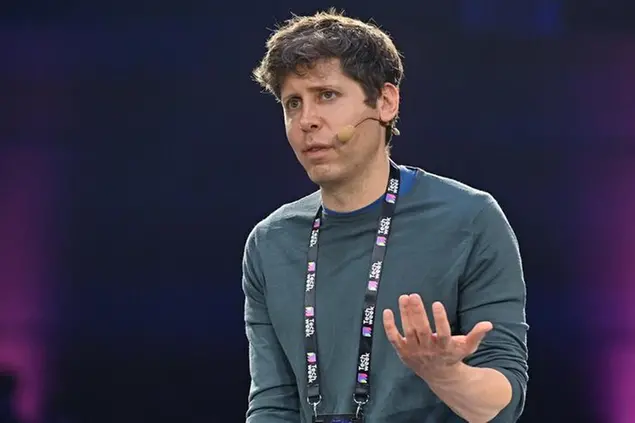

Se c’è una questione centrale e complessa per chi, tra Kamala Harris e Donald Trump, siederà alla scrivania della Sala Ovale, è la gestione dell’intelligenza artificiale. Il termine “gestire” non è casuale. Diversamente dall’Europa, gli Stati Uniti ospitano giganti tecnologici come Google (guidata da Sundar Pichai) e OpenAi (con Sam Altman come ceo) che, sviluppando e vendendo questa tecnologia, stanno cercano di mantenere una posizione dominante nel mercato globale. Non solo imprenditori con alle spalle miliardi di dollari di investimenti, ma personaggi che spesso orientano il dibattito pubblico nazionale e internazionale con visioni del mondo che portano acqua al loro mulino.

Ad avallare la prospettiva del dominio tecnologico americano è stato anche Donald Trump durante il suo mandato da presidente, nel 2019, attraverso l’American Ai Initiative. L’ordine esecutivo mirava proprio a promuovere – senza troppe indicazioni pratiche – la ricerca e lo sviluppo dell’intelligenza artificiale a stelle e strisce nel mondo. Attualmente non esiste una legge federale specifica che regoli il settore dell’intelligenza artificiale negli Stati Uniti.

Tuttavia, il regolamento europeo entrato in vigore nell’estate del 2023, pur visto come troppo restrittivo da alcuni, ha stimolato il dibattito anche oltre oceano. Diverse agenzie governative statunitensi, come la Federal Trade Commission (Ftc) e la Food and Drug Administration (Fda), hanno già emesso linee guida e regolamenti settoriali che coinvolgono anche l’intelligenza artificiale, ma l’esigenza di una regolamentazione più ampia e coerente è evidente.

Costi ambientali

D’altronde, secondo Trump, stringere troppo le cinghie porterebbe a uno stallo del mercato che gli Stati Uniti non si possono permettere, soprattutto se dall’altra parte della bilancia c’è la Cina. E in termini di sicurezza dei dati dei cittadini, dei datacenter e in generale delle infrastrutture critiche del settore, per Trump non c’è nessun dibattito che tiene: l’unica sicurezza su cui concentrare il suo operato è quella nazionale, minacciata dalla Cina. Dall’altra parte, la candidata democratica Kamala Harris è a favore di un bilanciamento nella regolamentazione dell’intelligenza artificiale che protegga i cittadini dalla disinformazione e dall’abuso tecnologico.

Nessuno dei due pone l’attenzione però sul tutt’altro che inaspettato impatto energetico dell’intelligenza artificiale. L’addestramento e l’utilizzo di modelli di Ia di grandi dimensioni richiedono quantità crescenti di energia, con conseguenti emissioni di gas serra. I consumi energetici dei data center, fondamentali per l’elaborazione dei dati, raggiungono ormai cifre paragonabili a quelle di interi paesi, aumentando le preoccupazioni ambientali.

Una questione sollevata in Texas dalla Public Utility Commission, l’ente regolatore dei servizi elettrici, telefonici e idrici, che ha il timore che l’infrastruttura pubblica alla quale i data center si approvvigionano non riesca a tenere il passo ancora per molto. I data center si stabiliscono infatti vicino alle centrali elettriche esistenti e ne acquistano la fornitura, rendendo di fatto più complesso per la rete sostenere la richiesta proveniente da altri. L’ente ha dunque imposto agli operatori di data center che vogliono aprire un business nei prossimi 12-15 mesi nello stato di garantirsi da soli una parte della fornitura energetica.

Il problema dell’approvvigionamento è in vista, e i grandi colossi tecnologici guardano già oltre. Questa primavera Amazon ha pagato 650 milioni di dollari per il data center Cumulus di Talen Energy, situato direttamente nelle adiacenze della centrale nucleare da 2,5 gigawatt sul fiume Susquehanna. In base all’accordo, Amazon avrà accesso a un massimo di 960 megawatt di potenza. Di nucleare ha parlato anche Sundar Pichai, Ceo di Google: l’energia nucleare potrebbe un giorno alimentare anche alcuni dei data center per l’intelligenza artificiale dell’azienda, anche se ciò striderebbe non poco con il raggiungimento dell’obiettivo emissioni nette pari a zero entro il 2030.

Regolamentazioni

La California, come spesso accade, guida il dibattito nazionale in materia di intelligenza artificiale e tecnologia. Il governatore democratico Gavin Newsom ha recentemente presentato tre nuove leggi volte a regolamentare le tecnologie deepfake e il loro impatto, non solo sulla vita quotidiana dei cittadini, ma anche sulla politica statunitense. Le tecnologie deepfake, che permettono di combinare immagini e video esistenti con elementi generati artificialmente, vengono utilizzate ormai da circa un decennio, spesso per creare contenuti pornografici o manipolare il dibattito politico. Durante le elezioni, queste tecnologie possono orientare l’opinione pubblica attraverso immagini e audio falsi, attribuiti a politici in contesti mai avvenuti.

Le leggi proposte da Newsom, di cui una già entrata in vigore, puntano a porre dei limiti alla diffusione di contenuti deepfake che prendono di mira candidati politici o che mettono in dubbio l’esito delle elezioni. In particolare, una legge prevede un requisito obbligatorio per le piattaforme di social media per combattere la disinformazione politica: le obbliga a rimuovere o etichettare contenuti falsi entro 72 ore dalla segnalazione. L’applicabilità di tali leggi è prevista sia nei 120 giorni prima delle elezioni sia nei 60 giorni successivi, con l’obiettivo di arginare la disinformazione anche durante lo spoglio dei voti.

L’importanza di regolamentare il deepfake è stata sottolineata quest’anno da un caso celebre: Elon Musk ha condiviso su X (ex Twitter) un deepfake che rappresentava Kamala Harris in una falsa dichiarazione su questioni di diversità. Questo episodio dimostra come tali tecnologie possano influenzare il dibattito politico in modo subdolo e potenzialmente decisivo. Harris, da procuratrice generale della California, aveva già promosso la redazione di leggi che limitassero l’uso dei deepfake in ambito politico, soprattutto durante le elezioni presidenziali.

Nonostante le buone intenzioni, l’efficacia di queste leggi verrà valutata solo nel tempo. Una delle sfide principali risiede nel bilanciamento tra regolamentazione e protezione della libertà di espressione, tutelata dal Primo Emendamento della Costituzione degli Stati Uniti. In aggiunta, la Sezione 230 del Communications Decency Act protegge le società tecnologiche dalla responsabilità sui contenuti pubblicati dagli utenti, rendendo complicata l’attuazione di normative più severe. La direttrice di Electronic Frontier Foundation, un’organizzazione non governativa statunitense che da decenni promuove la privacy, Hayley Tsukayama, ha commentato le nuove leggi californiane esprimendo dubbi sulla capacità delle piattaforme di identificare cosa sia davvero un discorso ingannevole, cosa satira e cosa sia un discorso protetto dal Primo emendamento.

© Riproduzione riservata